NUEVA YORK.- La tecnología avanza a pasos agigantados y cabe suponer que frente a esta oleada sería bueno preguntar si en este marcado avance ¿a quién responsabilidad por violar una ley respecto de la inteligencia artificial?; porque es de suponer que sea la AI quien conduzca los automóviles.

En esta colaboración participó un tecnólogo así como un abogado para examinar el futuro de la ley respecto de la AI.

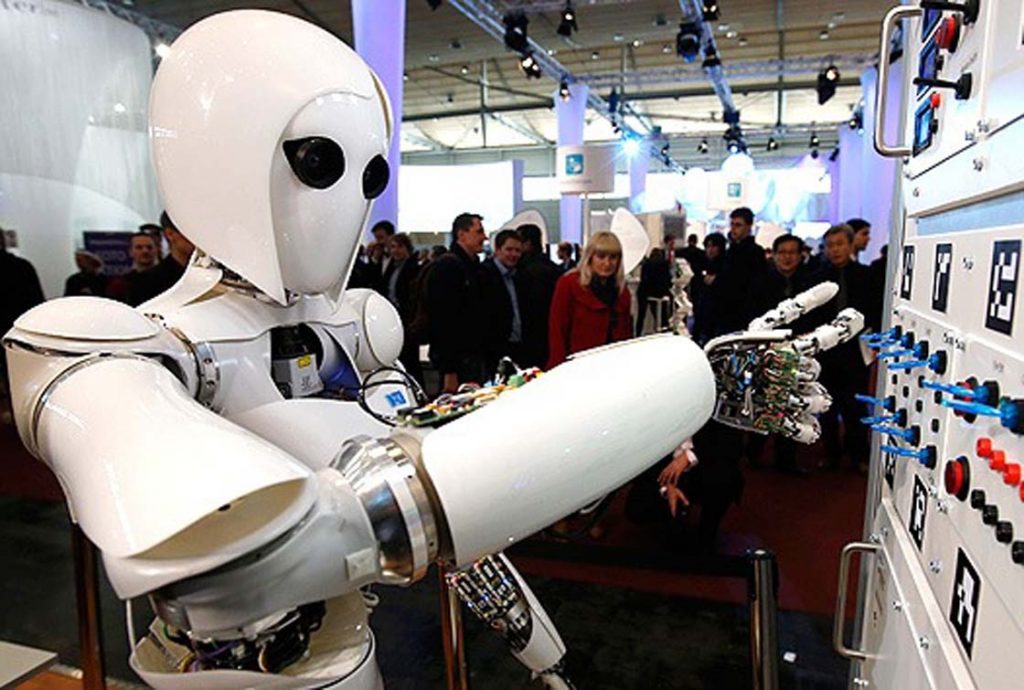

El campo de la IA está en una especie de renacimiento, con instituciones de investigación y gigantes de I + D que empujan los límites de lo que es capaz de hacer. Aunque la mayoría de nosotros no somos conscientes de ello, los sistemas de AI están en todas partes, desde aplicaciones bancarias que nos permiten depositar cheques con una imagen, a todos los filtros favoritos de Snapchat, a nuestros asistentes móviles de mano.

En la actualidad, uno de los grandes desafíos que los investigadores de AI están abordando es el aprendizaje por refuerzo, que es un método de entrenamiento que permite a los modelos de IA aprender de sus experiencias pasadas. A diferencia de otros métodos de generar modelos de AI, el aprendizaje de refuerzo se presta a ser más como ciencia ficción que como realidad. Con el aprendizaje de refuerzo, creamos un sistema de clasificación para nuestro modelo y la IA debe determinar el mejor curso de acción con el fin de obtener una puntuación alta.

La investigación en problemas complejos de aprendizaje de refuerzo ha demostrado que los modelos de IA son capaces de encontrar métodos variados para lograr resultados positivos. En los próximos años, podría ser común ver el aprendizaje de refuerzo integrado con más soluciones de hardware y software, a partir de señales de tráfico controladas por AI capaces de ajustar la sincronización de la luz para optimizar el flujo de tráfico a los drones controlados por IA capaces de optimizar las revoluciones del motor Para estabilizar videos.

¿Cómo tratará el sistema legal el aprendizaje del refuerzo? ¿Qué pasa si la señal de tráfico controlada por AI se entera de que es más eficiente cambiar la luz un segundo antes de lo que se había hecho anteriormente, pero eso hace que más conductores ejecuten la luz y causen más accidentes?

Tradicionalmente, las interacciones del sistema legal con software como la robótica sólo encuentran responsabilidad cuando el desarrollador fue negligente o podría prever daños. Por ejemplo, Jones v. W + M Automation, Inc., un caso del estado de Nueva York en 2007, no encontró al acusado responsable cuando un sistema de carga de pórtico robótico lesionó a un trabajador porque el tribunal determinó que el fabricante había cumplido con los reglamentos .

Es poco probable que entremos en un futuro distópico donde AI es responsable de sus propias acciones.

Pero en el aprendizaje de refuerzo, no hay culpa de los seres humanos y no hay previsibilidad de una lesión de este tipo, por lo que la ley tradicional del agravio diría que el desarrollador no es responsable. Eso ciertamente pondrá en peligro a Terminator si AI continúa proliferando sin responsabilidad alguna.

La ley tendrá que adaptarse a este cambio tecnológico en un futuro próximo. Es improbable que entremos en un futuro distópico donde AI es responsable de sus propias acciones, dada la personalidad y llevado a la corte. Eso supondría que el sistema jurídico, que se ha desarrollado durante más de 500 años en el derecho consuetudinario y en diversos tribunales de todo el mundo, podría adaptarse a la nueva situación de la AI.

Pero realmente la pregunta es si la IA debe ser responsable si algo va mal y alguien se lastima. ¿No es ese el orden natural de las cosas? No regulamos el comportamiento no humano, como animales o plantas u otras partes de la naturaleza. Las abejas no son responsables de picarte. Después de considerar la capacidad del sistema judicial, la realidad más probable es que el mundo necesitará adoptar un estándar para la IA donde los fabricantes y desarrolladores acuerdan acatar las directrices éticas generales, como por ejemplo mediante un estándar técnico obligatorio por tratado o regulación internacional . Y esta norma se aplicará sólo cuando es previsible que los algoritmos y los datos pueden causar daño.

r3